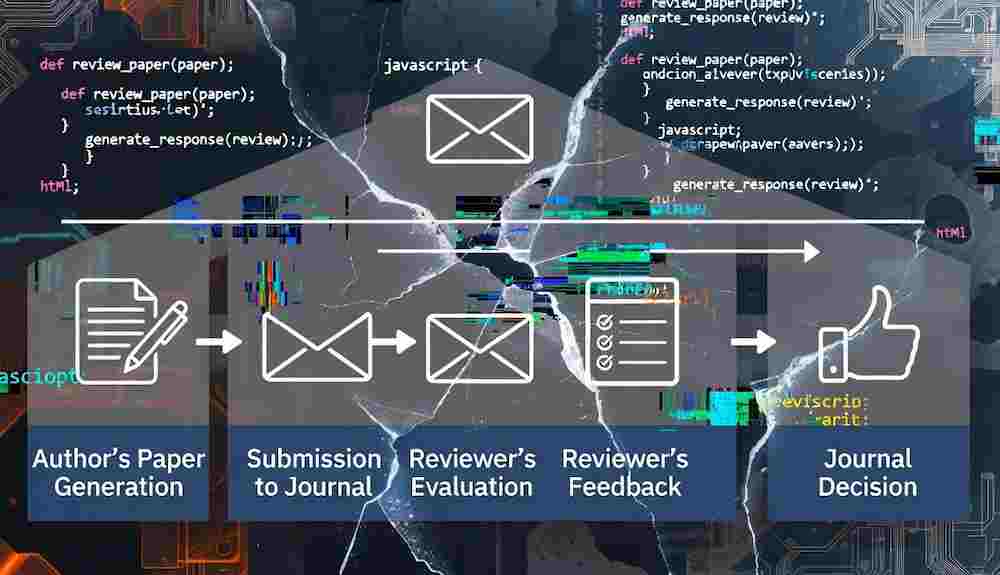

인공지능(AI) 분야의 최고 권위 있는 국제 컨퍼런스 중 하나인 ICLR 2026 준비 과정에서 생성형 인공지능이 학계의 오랜 신뢰 기반인 동료 심사 시스템에 심각한 균열을 내고 있다. Reddit에서의 토론등을 따르면 생성형 AI가 양측의 연구에 대한 신뢰를 어떻게 약화시키고 있는지를 드러낸다. 저자들은 가짜 출처를 만들어내고, 심사자들은 AI에 보고서를 맡기는 무책임한 행태가 만연하고 있으며, 이는 단순한 개인의 일탈을 넘어선 구조적인 문제로 진단된다. 2024년 발표된 한 연구는 이러한 문제들이 구조적인 압력에서 비롯되었다는 비판적 맥락을 더했다.

가짜 인용과 AI 작성 심사평: 무너지는 학술 출판의 신뢰

저자 측의 문제를 보여주는 대표적인 사례는 'BrainMIND'라는 논문이다. 조지아 공대와 중국 칭화대 연구진이 발표한 이 논문은 해석 가능한 뇌 활동 매핑을 다루었으나, 심사 과정에서 무수히 많은 가짜 인용이 발견되며 논란이 됐다. 참고 문헌 목록에는 완전히 조작된 제목과 공저자로 'Jane Doe' 같은 자리표시자 이름이 포함되어 있었다. 심사자들은 언어 모델의 명백한 사용을 지적하며 강력한 거부 의견을 냈고, 결국 저자들은 논문을 철회했다.

반면, 심사자 측의 무책임을 보여주는 사례도 있다. 'Efficient Fine-Tuning...' 논문 저자들은 심사위원들이 논문을 읽지 않고 생성형 인공지능 도구로 피드백을 생성했다며 논문 철회 의사를 밝혔다. 심사평은 논문의 본문과 부록에 명확히 설명된 실험이나 방법을 놓쳤다고 저자들은 비판했다. 저자들은 심사위원의 동료 심사 의무를 노골적으로 훼손하는 AI 남용 행태를 강하게 규탄했다. 물론, 비원어민 저자를 위한 언어 교정 등 논문의 문법적 완성도를 높이는 데 AI 기능을 활용하는 것은 학계에서 일반적으로 용인된다.

'층층이 가중'되는 실적 압박과 연구 윤리의 괴리

동료 심사 시스템 신뢰 붕괴의 근원은 개인의 태만을 넘어선 근본적인 구조적 문제에 있다. 장신쿠와 왕펑이 발표한 연구에 따르면, 중국의 '이중 일류(Double First-Class)' 프로젝트와 같은 정부 프로그램이 대학 내부에 유해한 인센티브 시스템을 생성하고 있다. 연구자들은 이를 '층층이 가중(cengceng jiama)'되는 압력 메커니즘으로 설명한다. 국가 정책 목표가 대학 순위 목표로 전환되고, 학과 차원에서는 비현실적인 학술 출판 할당량으로 강화되는 식이다.

이러한 강제적인 생산성 요구는 연구자들이 윤리적 기준에서 벗어나 결과를 추구하게 만드는 '목표-수단 분리(goal-means decoupling)' 현상을 낳는다. 연구는 일부 젊은 과학자들이 직위를 유지하기 위해 자료를 위조하거나 대필 작가를 고용하는 것 외에 "선택의 여지가 없었다"고 고백한 사례를 기록하고 있다. 2023년 출판사 힌다위가 철회한 9,600여 건의 논문 중 80% 이상이 중국 연구진과 관련되었다는 통계는 이 압박의 심각성을 방증한다. 더 심각한 것은 대학 행정 당국이 대외적인 평판과 순위를 유지하기 위해 작은 윤리적 문제들을 묵인하는 경향이다. 연구 효율성을 저해하지 않기 위해 부정을 너무 엄격하게 처벌하지 않는다는 대학 관계자의 발언은 학술 기관의 연구 윤리에 대한 이중적인 태도를 보여준다.

앞으로의 전망

생성형 인공지능이 학술계에 가져온 부정적인 영향은 피할 수 없지만, 미래에는 해법의 일부가 될 가능성이 높다. 앞으로 학계는 AI가 생성한 가짜 인용과 성의 없는 심사평을 탐지하고, 동료 심사 과정의 투명성을 높이는 데 AI 기반 도구를 필수적인 장치로 채택할 것이다. 궁극적으로는 기술적 검증과 함께 비현실적인 학술 출판 할당량을 줄이는 구조적 개혁만이 학술 시스템의 신뢰를 회복하고 연구 윤리를 재정립할 수 있을 것이다.